Classificação Multirrótulo: Calculando Medidas de Avaliação - Parte 5 (Final)

Oi pessoal, retornando aqui com a continuação e parte final desta pequena série de artigos! Terminamos as medidas de avaliação de desempenho baseadas em instâncias. Vamos agora estudar as medidas de avaliação baseadas em rótulos! Caso você esteja com dúvida sobre o qual e é instância e rótulos, sugiro consultar este artigo aqui!

Introdução

As medidas baseadas em rótulos são as seguintes: Macro-F1 (F1-Ma), Micro-F1 (F1-Mi), Macro-Precisão (PMa), Micro-Precisão (PMi), Macro-Revocação (RMa), Micro-Revocação (RMa), CLP, MLP e WLP.

As medidas de avaliação Macro-Precisão, Macro-Revocação e Macro-f1 primeiro calculam cada rótulo individualmente e somente depois calculam a média entre todos os rótulos, atribuindo assim pesos iguais para os rótulos - independente se o rótulo é frequente, infrequente ou raro.

Um rótulo é frequente quando ele ocorre muitas vezes nos dados, infrequente é quando a sua frequência é bem baixa, e raro é quando o rótulo realmente quase não ocorre nos dados. Já nas medidas Micro-Precisão, Micro-Revocação e Micro-F1 os rótulos são calculados todos juntos. O desempenho de rótulos raros acaba por influenciar medidas macro média, enquanto as medidas micro média são mais influenciadas pelos rótulos mais comuns.

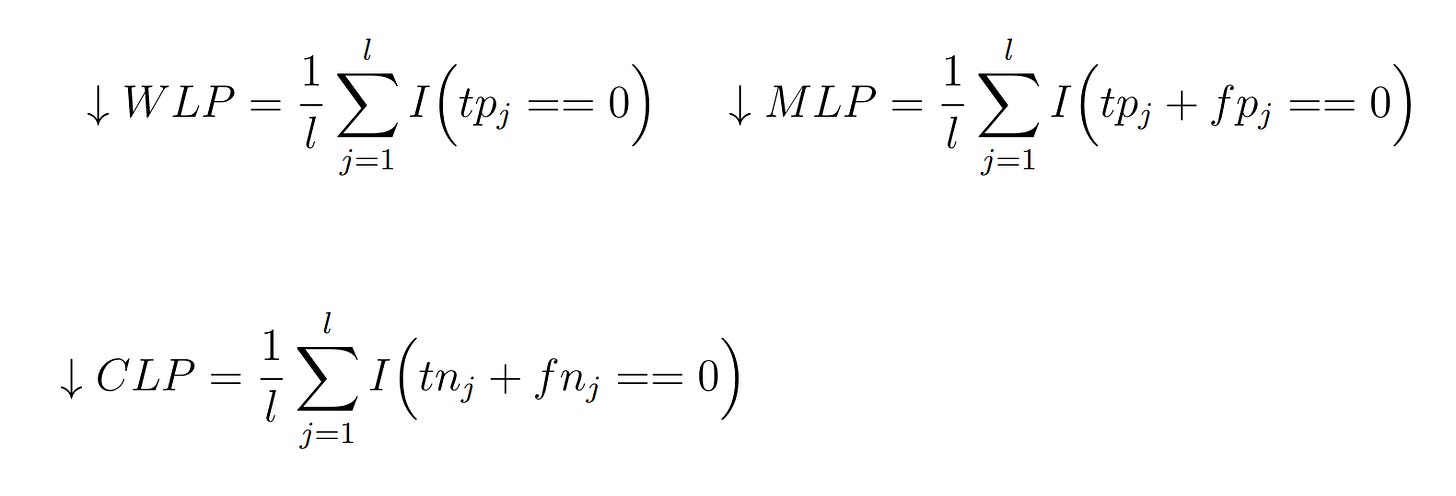

Podemos usar três medidas para mensurar predições errôneas de rótulos. A primeira medida é denominada Wrong Label Prediction (WLP) e mede quando o rótulo pode ser predito para algumas instâncias, mas essas predições estão sempre erradas. A Missing Label Prediction (MLP) permite calcular a proporção de rótulos que nunca são preditos.

A terceira métrica, Constant Label Problem (CLP), mede quando o mesmo rótulo é predito para todas as instâncias. Para CLP (rótulos preditos incorretamente), WLP (rótulos nunca preditos) e MLP (rótulos sempre preditos) o valor de retorno ideal é zero, indicando que não há ocorrências destes problemas nas predições dos rótulos.

Nas equações apresentadas a seguir consideramos TP os true positive, TN os true negative, FN os false negative, e FP os false positive, assim como já estudamos anteriormente nesta série. A letrinha j que aparece nas equações indica um rótulo específico, já que fazemos o cálculo por rótulos. No nosso dataset de exemplo esse j vai ser o L1, L2, L3, L4, e L5.

Vamos calcular uma por uma agora para o nosso exemplo.

1) Macro-Precisão

Note que fazemos o cálculo por rótulos: primeiro somamos os verdadeiros positivos com os falsos positivos do rótulo 1 e então dividimos os verdadeiros positivos do rótulo 1 por esta soma. Repetimos isso para todos os outros rótulos, somamos todos eles e então multiplicamos por 1/5 pois temos 5 rótulos. Nós vamos fazer exatamente este cálculo.

Pegamos os valores correspondentes da Matriz de Confusão e calculamos. Com isso temos o valor da Macro-Precisão. Esse resultado (0.43) não é tão bom pois está um pouco longe de 1.

2) Macro-Revocação

Na Macro-Revocação somamos os verdadeiros positivos com os falsos negativos e então dividimos os verdadeiros positivos por esse resultado. Então, fazemos o mesmo para todos os rótulos, somamos os resultados e multiplicamos por 1/5. Calculando:

Notem que, no cálculo do L5 houve divisão por zero, então, decido que todas as divisões por zero serão substituídas por zero! Obtemos um valor baixo como resultado (0.48) pois está bem longe de 1.

3) Macro-F1

A Macro-F1 é bem fácil de calcular, basta substituirmos os valores encontrados anteriormente na fórmula!

2 * 0,43 * 0,48 / 0,43 + 0,48 =

0,418888888888889 / 0,916666666666667 =

0,456969696969697

O resultado da Macro-F1 portanto é 0,46.

4) Micro-Precisão

Nesta esquação somamos os verdadeiros positivos de todos os rótulos e depois dividimos o resultado pela soma dos verdadeiros positivos com os falsos positivos. Agora resolvemos a equação e obtemos o valor de 0.5 como resultado.

5) Micro-Revocação

Notem que na Micro-Revocação primeiro somamos os verdadeiros positivos de todos os rótulos e dividimos esse valor pela soma de todos os verdadeiros positivos com os falsos negativos. Calculando:

A soma de todos os verdadeiros positivos vale 5, enquanto os falsos negativos valem 7, calculando obtemos 0.4 como resultado.

5) Micro-F1

A Micro-F1 é bem fácil de calcular, basta substituirmos os valores encontrados anteriormente na fórmula!

2 * 0,5 * 0,4 / 0,6 + 04 =

0,379 / 0,871 =

0,434

O resultado da Micro-F1 portanto é 0,434.

6) Constant Label Problem

Para calcular a CLP devemos usar os valores da matriz de confusão e fazer o seguinte:

R1 = ( ( TN1 + FN1 ) == 0)

R2 = ( ( TN2 + FN2 ) == 0)

R3 = ( ( TN3 + FN3 ) == 0)

R4 = ( ( TN4 + FN4 ) == 0)

CLP = 1/l ∗ (R1 + R2 + R3 + R4)

Na planilha ficará assim:

Quando somamos TN com FN para L1, temos que 1 + 2 = 3 e, portanto, não é igual a zero. O resultado será ZERO neste caso! Note que a mesma situação ocorre com os outros labels. Depois de somar cada rótulo individualmente, somamos o resultado deles e multiplicamos por 1/5 pois temos 5 rótulos. O valor zero é um ótimo resultado.

7) Missing Label Problem

Com esta medida faremos algo parecido com a anterior.

R1 = ( ( TP1 + FP1 ) == 0 )

R2 = ( ( TP2 + FP2 ) ==0 )

R3 = ( ( TP3 + FP3 ) == 0)

R4 = ( ( TP4 + FP4 ) == 0)

MLP = 1/l∗( R1 + R2 + R3 + R4 )

Na planilha ficará assim:

Temos aqui uma situação similar à medida CLP! O resultado zero é o melhor para estas medidas!

8) Missing Label Problem

Aqui calcularemos da seguinte forma:

R1 = ( TP1 == 0 )

R2 = ( TP2 == 0 )

R3 = ( TP3 == 0 )

R4 = ( TP4 == 0 )

WLP = 1/l∗( R1 + R2 + R3 + R4 )

Na planilha ficará assim:

Todas as medidas de problema de predição resultaram em zero o que é bom!

Conclusão

Pessoal, com isto terminamos as medidas de avaliação para Classificação Multirrótulo. Existem medidas para avaliar os algoritmos de ranqueamento multirrótulo, mas estas não são medidas que precisaremos para avaliar os classificadores, que são o foco destas séries de artigos! Espero que vocês tenham gostado dos artigos até aqui. Para quem quiser, pode fazer o download da planilha aqui! Vejo vocês no próximo artigo!

Este artigo foi escrito por Elaine Cecília Gatto - Cissa e publicado originalmente em Prensa.li.