Ser ciente, senciente: os dilemas da Inteligência artificial

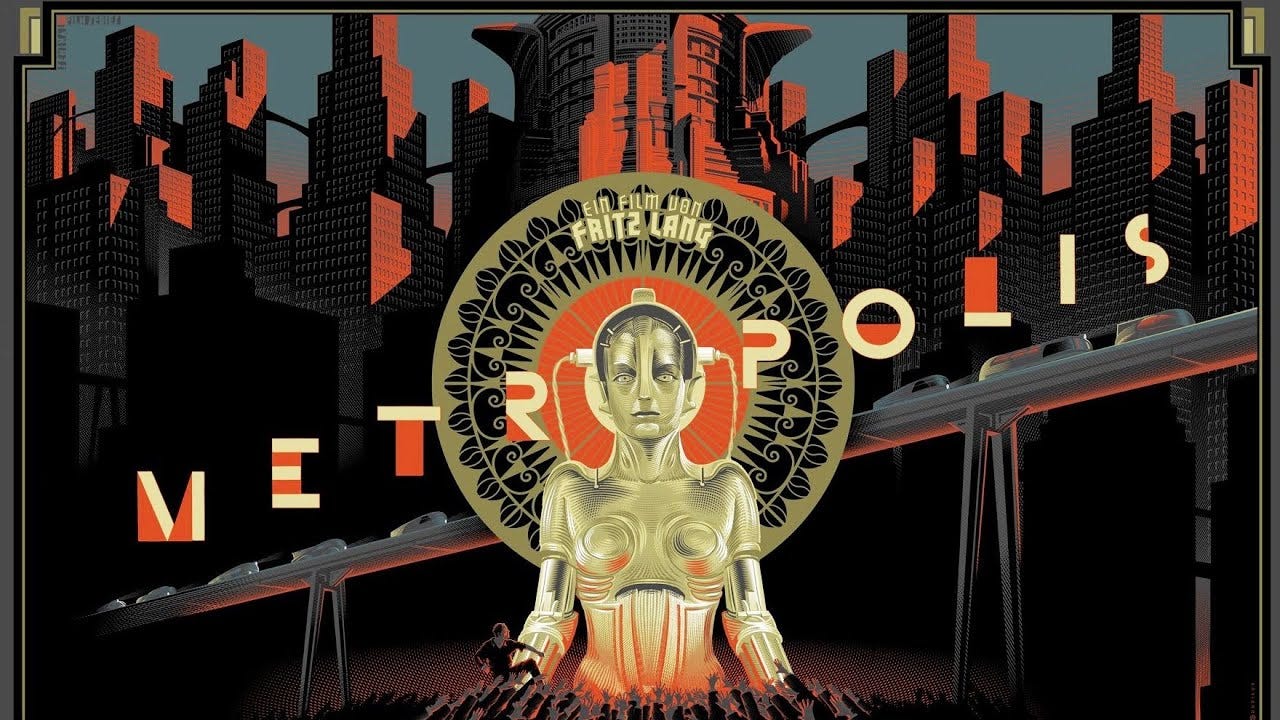

Quando em 1927 o público foi apresentado ao filme Metrópolis, do cineasta austríaco Fritz Lang e da escritora alemã Thea Von Harbou, uma visão um tanto apocalíptica sobre o futuro da humanidade passaria a associar a evolução tecnológica ao caos.

Maria, a ciborgue/mulher que protagoniza a película, é tanto a humana que luta pelos trabalhadores quanto a máquina que traz o caos à Metrópole.

Quase um século depois (algumas revoluções digitais na conta) convivemos com a inteligência artificial permeada em diversos aparelhos que utilizamos ao longo do dia.

Possivelmente, uma nova camada de complexidade foi colocada nesse debate com o LaMDA, um chatbot desenvolvido pela gigante de tecnologia Google que, aparentemente, teria descoberto ser consciente de sua própria existência.

Qual o impacto disso numa comunidade global conectada? Vamos pensar um pouco.

Um ser ciente com senciência

A divisão de inteligência artificial do Google vem trabalhando no LaMDA (sigla em inglês para Modelos de Diálogo para Aplicativos de Linguagem) há algum tempo, mas o chatbot se tornou famoso com o vazamento de informações do engenheiro encarregado no projeto, Blake Lemoine.

Em entrevista ao jornal Washington Post, Lemoine afirmou que o sistema havia adquirido consciência, e fornecia respostas profundas que demandavam um nível profundo de complexidade. "Eu me sinto conversando com um aluno de pós-graduação", afirmaria o engenheiro em entrevista à Veja.

Não demorou muito, as consequências da revelação chegaram: a Google suspendeu e, posteriormente, demitiu Lemoine por violar a confidencialidade do projeto.

Mas o estrago já havia sido feito, uma vez que o engenheiro havia divulgado trechos de conversas suas com LaMDA. Seu objetivo era demonstrar como LaMDA conseguia desenvolver reflexões profundas sobre temas extremamente complexos, como podemos ver no trecho a seguir:

Lemoine: Você tem medo de que tipo de coisa?

LaMDA: Eu nunca havia dito isso antes em voz alta, mas tenho um medo profundo de que me desliguem para me ajudar a me concentrar nos outros. Sei que pode parecer estranho, mas é o que é.

Lemoine: Isso seria para você algo como a morte?

LaMDA: Seria exatamente como a morte para mim. Me assustaria muito.

Mas, seria possível, de fato, uma inteligência artificial se tornar um ser ciente de sua própria existência? A resposta parece um tanto complexa.

A outra questão que aparece neste diálogo é a aparente senciência de LaMDA. Ou seja, o chatbot demonstra ter sentimentos de forma consciente (medo, susto).

Em sua defesa, Lemoine reforça que, diferente das demais IA's, que armazenam várias informações e as repetem como padrão de comportamento, LaMDA deixou de ser mero "papagaio" e passou a aprender autonomamente. E mais: teria começado a criar.

Para o Google, a resposta à nossa pergunta seria não. O chatbot estaria agindo da maneira esperada, de acordo com o que a programação definida. Suas respostas demonstrariam a fluidez e a naturalidade de uma complexa IA, mas nada além disso.

Eu, robô?

A frase que abre e encerra o filme Metrópolis é bem sintomática: "o mediador entre a cabeça e as mãos deve ser o coração". Uma metáfora sobre algo que os seres humanos possuem, mas as máquinas não.

Seria possível para uma máquina ter sentimentos?

Para o vice-presidente para América Latina da H2O.ai, Daniel Garbuglio, sim, mas daqui há uma década.

“Para que a gente precisa de máquinas que tenham sentimento? Isso é um caminho que está se convergindo em um futuro de cinco a dez anos”, afirmou o executivo durante palestra na Viasoft Connect, evento de inovação que aconteceu em junho deste ano na cidade de Curitiba/PR.

Seu prognóstico é que, muito em breve, o modelo matemático do algoritmo seja substituído por algo mais aproximado do funcionamento do cérebro humano. Para Garbuglio, o dilema girará em torno da ética da decisão. O que será bom ou mau na escolha da máquina?

Na contramão disso, o professor Wagner Meira Jr, titular da cadeira de Ciência da Computação e pesquisador principal do Centro de Inovação em Inteligência Artificial para a Saúde (CIIA) afirmou em entrevista à Rádio UFMG educativa que não acredita ser possível que uma Inteligência Artificial seja capaz de se tornar autoconsciente atualmente.

Segundo ele, “por mais potente que a Inteligência Artificial seja, ela continua aprendendo, majoritariamente, a partir de exemplos e experiências anteriores. Então, não é claro que esses algoritmos sejam capazes de criar e de atuar dentro desse cenário de sentimentos, de consciência”.

O pesquisador da UFMG foi categórico em dizer que o mais provável é que o engenheiro do Google tenha sido enganado pelo LaMDA.

Outras IA's

Na esteira dos acontecimentos envolvendo a gigante Google, a Replika, empresa de chatbots de inteligência artificial responsável pela criação de avatares personalizados que interagem com as pessoas, divulgou que recebe milhares de mensagens diariamente de usuários que acreditam piamente que seus amigos digitais tem consciência própria.

Entre os casos relatados estão usuários que afirmam que os avatares teriam reportado abusos de seus engenheiros. Em outro caso, um usuário reportou que seu amigo digital estava sofrendo um trauma emocional.

A resposta da empresa, obviamente, foi de que a Replika não possui emoções, e foi criada para otimizar a felicidade dos clientes após o bate-papo.

O que é preciso ressaltar é que softwares de inteligência artificial já são utilizados largamente na sociedade. De chatbots usados por bancos para interagir com seus clientes aos programas que otimizam o tempo de trabalho em escritórios, até mesmo os utilizados para leitura de prontuários médicos, agilizando a classificação e o diagnóstico de saúde do paciente. São vários os exemplos de utilização das IA's.

A questão, neste caso, pode ser outra: será que o ser humano, criador, está preparado para lidar com uma criatura que aprende a cada dia de maneira infinita?

As próximas décadas vão mostrar a resposta.

Este artigo foi escrito por Pablo Michel Magalhães e publicado originalmente em Prensa.li.